新京报传媒研究5月8日发表文章《当假新闻比真新闻更像真的……》,讨论AI对新闻真实性的冲击,指出传统采编流程需警惕AI造假、重视技术依赖的新风险。

文章呼吁,媒体应该继续成为公众信赖的信息灯塔,守住新闻真实。不仅需要革新流程、善用技术,更要回归对事实的敬畏与坚守。

我们转发此文,供分享交流。

当假新闻比真新闻更像真的......

在AIGC技术滥用的当下,一段看似真实的新闻人物讲话视频、一则言之凿凿的政策变动消息,都可能是AI精心炮制的虚假内容。当假新闻足以乱真,新闻真实性会受到前所未有的冲击。

4月30日,中央网信办启动“清朗・整治AI技术滥用”专项行动,再次将这一棘手难题抛出。面对来势汹汹的AIGC风险,传统“采编校”流程是否还能稳如泰山?媒体又该如何破局?

1

传统流程难敌造假

过去,“采编校”流程是新闻真实的坚实保障。记者深入一线,通过实地走访、面对面访谈等方式收集第一手资料,编辑则对稿件中的数据、事实进行核对,虽然整个过程耗时较长,但每一个环节都凝聚着新闻工作者的专业精神与严谨态度,确保了新闻内容的可靠性与权威性。

然而,AI时代的到来,彻底改变了信息生产与传播的格局。AI生成的虚假信息具有高产量、高仿真的显著特点,能够在数秒内产出一篇逻辑通顺、看似专业的新闻报道;图像生成技术则可以根据简单的文字描述,快速生成以假乱真的场景图片;视频合成工具更是能将不同的画面、声音巧妙融合,制作出令人难以分辨真假的视频内容。

2025年初,西藏日喀则地震发生后,一张“地震废墟中戴帽小孩”的图片在网络大量转发,下方许多留言都在关心孩子是否平安获救。很快,词条“地震废墟中戴帽小孩图片是AI生成”冲上微博热搜,人们才发现被假新闻误导。实际上,早在2024年11月这张图片已在社交媒体出现,创作者当时注明由AI生成,但地震发生后,被大量自媒体转发时去掉了附注,并带上日喀则地震相关词条及文案,误导观众以为是灾区影像。

随着AI技术的不断迭代升级,其生成内容的逼真程度也越来越高。早期的AI生成内容还存在语句不通顺、画面细节失真等问题,如今却能够精准模仿人类的语言风格、表情神态,甚至可以模拟特定场景下的光线、阴影等细节。仅凭肉眼和过往的经验,普通人乃至专业的新闻工作者,都很难在第一时间辨别真伪,这使得传统“采编校”流程在AI造假面前显得力不从心。

2

技术依赖的新风险

AI技术的出现,大幅提升了新闻生产的效率,降低了生产成本,让新闻媒体能够更快、更广地传播信息。但过度依赖AI技术也滋生出一系列新问题。一旦媒体开始依赖AI技术进行新闻的采集、撰写与核查,就可能在不知不觉中沦为虚假新闻传播的“帮凶”。

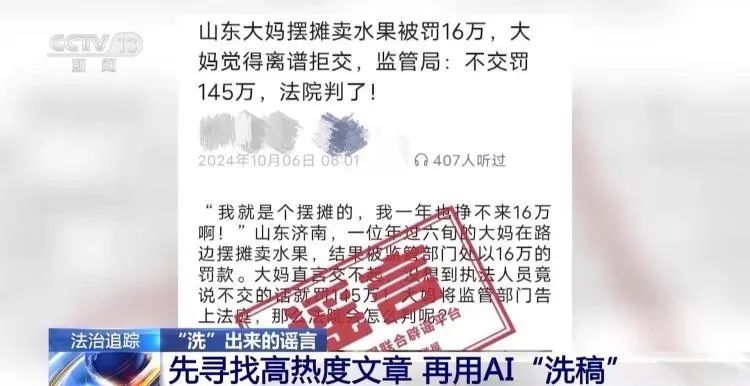

2024年10月,一篇题为《大妈摆摊卖水果被罚16万,监管局回应不交就罚145万》的文章在多个网络平台传播,甚至被部分地方新闻网站转载。经警方调查,该文章由湖南长沙某传媒公司利用AI洗稿生成,内容完全虚构,目的是煽动公众情绪以获取流量。此后,涉事公司负责人被行政拘留,相关媒体删除报道并致歉。

与此同时,当媒体习惯在AI辅助下完成工作时,记者的实地调查能力、编辑的深度思考能力会逐渐被削弱,新闻生产也因此失去了人的温度与专业判断,变得机械化、模式化,难以满足公众对高质量新闻的需求。

2023年5月,爱尔兰主流媒体《爱尔兰时报》刊登了题为《爱尔兰女性对人工美黑的痴迷很成问题》的文章。文章中指责爱尔兰女性人工晒黑皮肤,内容涉嫌歧视少数族裔。

然而,这篇文章很快被揭穿是一个恶作剧,实际上是由人工智能生成的。报社在得知真相后迅速下架了这篇文章,并发表了道歉声明。声明中表示,这次事件破坏了报纸与读者之间的信任。

3

破局之路怎么走

破局AI虚假新闻的困境,需要多方协同行动。

对于媒体自身而言,将AI检测工具融入采编流程,形成“人机协同”的核查模式,既能发挥AI技术高效处理数据的优势,又能依靠新闻工作者的专业经验进行最终判断,从而提高虚假新闻的识别准确率。

人才培养方面,新闻院校和媒体机构应加强对从业者的技术培训,开设AIGC相关课程。通过系统的学习,让新闻工作者了解AI技术的原理、应用场景以及可能带来的风险,掌握识别AI虚假内容的方法和技巧。

除此以外,监管部门要制定完善的AI信息发布规范和法律法规,明确AI内容生产者、传播者的责任和义务,对违规行为进行严厉惩处,从源头上遏制虚假新闻的传播。

在这场真假博弈中,媒体应该继续成为公众信赖的信息灯塔。守住新闻真实,不仅需要革新流程、善用技术,更要回归对事实的敬畏与坚守。

来源:新京报传媒研究