毕业论文写完那天,王子依进行第一次AIGC率(人工智能生成内容比例,以下简称AI率)检测。结果给了她重重一击:论文被系统判定70%为AI生成。

过去两年,湖北大学、福州大学、中国人民大学、中国传媒大学等多所高校将毕业论文的AI率纳入毕业答辩流程,并设置比率红线。

但许多学生发现,AI率检测结果并不稳定:不同平台差别大,有时甚至相互矛盾。写得越规范、用词越准确,AI率反而越高。有人引用公式、法条、经典文章被判“AI生成”,有人连致谢也被标红。

一边是学生想尽办法“降AI率”“向AI证明自己不是AI”才能参与答辩。模糊的判定标准下,还催生出一条隐秘的灰色产业链。

另一边是教师在教学中如何感知和把握AI“介入”。查还是不查、用还是不用、在哪个阶段使用算“作弊”?这些问题没有统一答案。

这一学术监管难题,正在困扰全球教育系统。AI率检测似乎在帮助识别“人”与“机器”的边界,但已有不少教师开始反思,当论文写作正好落入AI最擅长的范围时,当前的考核,是否已经悖离了教育的初衷?

▲即将毕业的大学生们在拍照留念。图源ic

降AI率,比写论文还难?

直到答辩前一周,王子依仍深陷AI率的困扰。

她就读于小学教育专业,毕业论文研究主题是“小学游戏化教学”。早在实习期间,她便完成问卷发放和数据收集的工作,原以为只需打磨内容、顺利答辩即可毕业。

今年年初学校发布新规,论文除查重外,还需接受知网“AI率”检测,并由个人在答辩前提交检测报告。检测结果原则上不得超过40%,若超出可能被认定为学术不端,将可能给予重写或延毕。

王子依坦言自己在数据分析部分使用过AI工具,进行样本独立性检验。但她发现,AI检测报告标出的多是一些格式规范,“其一”“其二”等分点阐述和名词解释被大面积标记,甚至连致谢中引用的一句歌词也未能幸免。

王子依尝试修改被标记的句子,但AI率始终在50%上下徘徊。她在社交媒体上发帖求助,很快涌来上百条评论。王子依注意到,最近一个月,常常会在凌晨两三点收到新的评论和收藏。

有学生称自己的论文在不同平台的AI率相差悬殊,免费网站查询60%,付费网站查询只有10%;有学生引用的古诗词被标注;有学生越改AI率越高;还有学生称自己将论文里的句号全部改成逗号,AI率降低了20%。

评论区里还有很多降AI率攻略。使用翻译软件,将中文内容转译为其他语种后再译回,结果语句生硬、逻辑错乱,连作者自己都读不下去。有人说可以添加“啊”“呢”“哦”之类的语气词。

甚至“魔法对轰”——“用AI降AI率”。王子依采用了这种方法,论文中原本结构清晰的教学设计,被转化成了口语化的“老师说什么、学生怎么回应”的对话体,她说,读起来像是一本儿童绘本。

新京报记者在评论区看到,也有学生质疑,“凭什么让AI定义我是不是AI”。来自一所高校首饰设计专业的赵霖有同样的疑惑,她的论文是作品说明的一部分,但学校规定AI率必须低于10%。她原本用AI帮忙润色语句,系统判定90%的内容是AI生成。

“我们是先做出作品,再写出想法,AI只是顺了顺语言。”她说,结果系统只看“像不像AI写的”,却完全无视思考过程。在她眼中,“抄袭”和“使用AI润色”是两回事。前者意味着没有贡献,后者则是一种辅助。但在AI率检测面前,这两者往往被同等对待。

在一遍一遍的修改和检测后,王子依觉得自己的论文“千疮百孔”,而她自己也像个被检测结果支配的AI。老师建议她先专注于内容,不必过分纠结检测。但她担心影响答辩,只能不断删减被标红的段落。

早在2024年6月,华东师范大学与北京师范大学联合推出《生成式人工智能学生使用指南》,要求确保AI生成内容不超过全文的20%;天津科技大学2024年的要求是AIGC检测不得超过40%;福州大学要求学生答辩前、答辩后进行两次AIGC检测,检测结果将作为成绩评定和优秀毕业论文评选的参考依据。今年以来,又有多所高校加入检测队伍。

许多学生开始紧盯每一次检测后的“数字”。多位学生表示,他们真正担忧的,是在一个模糊的系统面前,要想尽办法通过检测数字上的“达标”,才能获得参加答辩的资格。

▲王子依社交平台上收藏的降AI率的“攻略”。 受访者供图

“像不像AI”谁说了算?

经过大半个月的努力,王子依提交了知网检测AI率为20%的检测报告。但她却始终搞不懂AI率到底是怎么计算出来的。

北京航空航天大学法学院教授、数字正义研究中心执行主任裴炜分析,目前多数AI率检测系统是基于“语言预测”:通过分析大量AI生成文本,归纳出AI的语言习惯,比如一个词组后面通常会跟着哪些词等。再将其与学生论文进行比对,如果发现与AI生成文本的特征高度相似,就可能判定某段文字为“AI生成”。

然而,人类本来也会使用规范、重复的表达,尤其在学术写作、技术报告等规范性文本中。“AI生成”不是“AI原创”,而是AI基于人类创作的语料,模仿人类思考表达模式的产物。“换句话说,没有AI,人也可能做出类似的语词联系和表达”。

裴炜提到,当前AI率的判断技术本身存在不确定性。她试用过一些AI检测工具,发现“容易误伤”,直接使用和认定有可能错判学生的真实劳动成果。

另外,不同检测网站的原始数据库不同,也会造成检测结果的不同。一位人工智能方向的从业人员向新京报记者解释,由于大模型的算法内部机制和决策过程是黑箱式的,无法解释为什么这段话被判断为AI生成,只能给出一个结果,比如“AIGC率为73%”。

此前Open AI也在2023年1月发布一款AI文本检测工具“AI Classifier”,旨在确定文本是不是人工智能生成的,但由于准确率只有26%,于当年7月宣布停止。

而即便是人类的语言学专家,也很难分辨二者区别。

2023年,美国南佛罗里达大学的一项研究,邀请语言学专家区分AI生成的文字内容和人类写的内容,72名专家的正确率为39%。

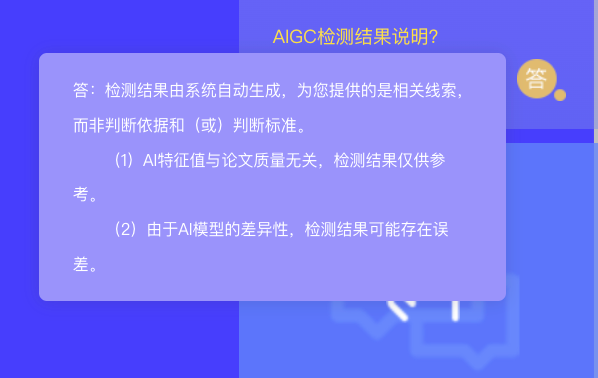

新京报记者也注意到,多个检测网站都标注了“免责说明”。“AI生成可能性及被标注的文本,仅表示具有AI生成文本的部分特征,并不确定为AI生成,结果仅供参考。”“由于AI模型的差异性,检测结果可能存在误差。”还有“AI特征值与论文质量无关,检测结果仅供参考”。

尽管AIGC检测的原理和准确性是模糊的,但学生们的焦虑很真实。

新京报记者在多个社交平台上发现“代降AI率”的广告,有的是利用AI网站降重,购买相应的字数,就能自动生成;也有提供人工降重服务,声称“一对一修改、改到满意”。价格从几十元到几百元不等,常按字数或目标AI率定价。

记者询问了几位“降AI率”服务博主,对方称一篇1万字、AI率45%的论文,花80元可以降到个位数,方法是“纯人工调整”。另一位按照修改的字数收费,千字10元。

另外,新京报记者看到,有检测平台一边提供检测AI率,一边销售“降AI率”服务。一家网站智能降AIGC的价格为每千字3-5元,自动改写AIGC疑似度高的片段;人工降重则需要添加客服微信,根据论文题目、检测结果、字数以及降到多少进行报价。

▲新京报记者在一个免费进行AI率检测的网站上看到,有付费进行降AI率的服务。图源:网络截图

“我不再是写作者,而是信息传送带”

在教学实践的另一端,无需检测,不少老师也能从论文中察觉出“AI味儿”。

表述奇怪、“不合年级水平”的表现、虚构的参考文献等——这些线索逐渐构成他们判断学生是否使用AI的依据。

陕西一所高校的会计专业教师彭玉发现,今年有人交上来的初稿结构还算完整、字数达标,但语言干巴,财务数据分析简单又笼统。“有点儿像在很大的数据库里搜点儿东西拼凑出来。”

她本担心误判,结果学生回复“好的”,答应重写。她意识到学生也心虚了。她还记得一个学生的致谢里,每个句子都是句号,对方也坦承“整页都是AI写的”。

类似的直觉也出现在小语种教学中。一位北京高校的小语种老师严远提到,自己所在的学校尚未启动AI率检测机制,但今年答辩时,他明显感受到,部分学生论文中展现出“与其学习阶段不匹配”的知识储备和表达水准。

他提到,AI对翻译类作业的影响尤其显著。学生提交的外译中文本中,充满排比、隐喻和修辞性的陌生表达。而中译外的文本,又过于流畅和自然。

西南财经大学社会发展研究院副教授陈晶环的“警觉期”更早。2022年底Chat GPT问世几个月后,她就注意到学生作业在质量上的明显跃升。

她最初还欣喜,后来却发现许多作业尽管使用了大量专业术语和书面表达,但句与句之间缺乏逻辑递进、语言空洞,甚至彼此相似。她感叹,如今看到不太流畅的句子,反而高兴,觉得是学生自己写的。她坦言,“老师也很矛盾。”

对于AI率检测,老师们态度不一。

彭玉所在学校今年首次设立AIGC率检测机制,规定学生论文中AI生成内容不得超过35%,检测费用每人最多可报销200元。她认为这项制度“至少能震慑一批人”。

裴炜则认为,即便是目前广泛使用的“重复率”,也在学位论文评价中存在缺陷。在法学专业中,很多术语和法律表达是固定的,如果为了“降重”而扭曲表达,反而有损论述的准确性和严谨性。相较于重复率,AI率的情况更为复杂,在现有技术和评价标准尚不成熟的情况下,直接予以适用可能制造更大的不公与误伤。

同时她认为人机协作的界限非常模糊,如何衡量一个学生在写作中投入了多少“自己的智力”?从简单输入一个标题就生成一整篇论文,到给出完整的研究问题、思路框架,再让AI完成扩展,或是让AI协助润色和修改文本,这之间很难用一个“率”去界定。

严远提到要警惕新的技术官僚主义。学生们用AI写论文、用AI查AI率,再用AI降AI率,变成了考察大家谁更会使用AI,变成教育者和被教育者之间的斗智斗勇。

陈晶环看到有被AI率误伤的大学生,“防守和进攻都靠AI,谁也没能真正走出AI的圈子。”她建议是否可以建立一个沟通解释机制。让学生可以提供一些初稿、改动痕迹等内容,而不是强硬地根据检测数字决定是否能参与答辩。

而在学业之外,AI对学生思维习惯的重塑更让部分教师警惕。

陈晶环将其称为“习得性求助”。“这是一种有问题第一反应就不再是自己思考,而是立刻去找AI。”这种习得性求助意味着学生主动思考的过程被跳过了:“我不再是写作者,而是信息传送带。”

她感受到,工具的过度使用不仅带来了思维能力的弱化,更削弱了学生的阅读力、耐心和表达欲望。“有学生甚至连AI给出的内容都不愿读完,只觉得前两句差不多,就直接复制进论文。”

而大学阶段最核心的成长,就在于是否形成了自主思考的习惯和能力。在她看来,这种被工具牵引和主导、逐渐失去主动权的过程,就是“异化”。

▲知网个人AIGC检测服务页面的常见问题解答中提到,AI特征值与论文质量无关,检测结果仅供参考,可能存在误差。图源:网络截图

AI无法替代人类对现实的感知与回应

夜里十一点,彭玉的微信又响起,是学生发来修改完的论文。

这样的情况她早已习惯。大四不少学生已在实习单位报到,重心不在学术上,而是如何尽快完成学业、顺利毕业。论文修改是他们在下班后,或者挤出周末的时间赶工出来的。在就业压力与工具便利的双重作用下,论文变成一项需要完成的“任务”。

本科毕业论文最初的设想,是训练学生的科研能力与培养探索精神,也就是“能不能提出一个研究问题,并进行系统性的分析”。

但陈晶环指出,在实践中,这个目标不断被“降维处理”。“我们已经不苛求本科生做出理论创新了,重点要求学生要有最基本的学术规范,只要他能用学术语言、说得通、讲得顺,就算合格。”

而表述结构清晰、语言规范、格式统一,这恰恰是AI最擅长模仿的领域。

严远直言,在如今的技术面前,传统的作业或者考核已经失去意义,像一场师生间的互相欺骗,“装作AI不存在。”

换句话说,目前高校的教育考核方式,已经难以适应人工智能等新工具的广泛使用。更有老师直言,这相当于用农业社会的考法,应对智能社会的工具。

裴炜认为不可能在AI技术高速发展的同时,又禁止学生使用。相反地,在未来社会,学生的数字能力、智能能力将是其核心竞争力。因此问题的关键不在于学生使用AI去应对考评,而在于AI时代教育理念、教育方式和人才评价机制需要与时俱进。

陈晶环认为,技术的变化正要求教育做出结构性调整——改变考核方式、更新评价指标、重塑教学目标。“这是教育的责任,而不是学生的负担。”

比起限制或一味禁止AI使用,多位教师提到,重点是在教育中正视工具的存在,并引导学生在使用中保持思维的主动权。严远注意到,一些学生通过AI辅助,能够更便捷地查阅多语种资料、了解语法细节,尤其是在教师未能覆盖到的地方,AI反而起到了“补课”作用。

面对这种趋势,老师们正主动调整,布置无法被AI完成的作业,或者让AI只能起到辅助作用。

陈晶环将课程论文写作改成口头汇报对某本社会学著作的理解,并且不使用PPT脱稿讲解,这样学生就必须在理解的基础上,用自己的语言表达。她还让学生书写个人生活史。这种非结构化、贴近生活的写作,迫使学生自己动手,无法靠AI代劳。在研究生课程上,她则鼓励学生有意识地探索AI的可能性。

严远尝试让学生翻译文本并配音。学生可以用AI翻译,但必须亲自配音。在小语种学习中,口头转述比笔头儿更能检验学习质量。

此外,严远在讲授生态环保等复杂议题时,课堂时间限制没办法拓展。他鼓励学生用AI梳理背景知识,再在课堂上讨论AI给出的观点。这种方式不仅拓宽了学生的视野,还激发了多元思考。“不同同学使用AI,有时会提出意料之外的观点,这反而让讨论更深入和多元。”

在裴炜看来,技术带来的变化是每一代人都要面对的。从更长远的尺度看,当AI更加深入地介入学术研究,学术诚信的边界如何划分,在文章中如何提及AI的贡献,AI能否列为论文作者,乃至如何定义学术诚信、合作、学术剽窃,可能都需要教育界和学术界一起慢慢探索。

采访中,陈晶环提到去大凉山做田野调查的故事。她长期关注彝族地区的农村基层治理,涉及当地特有的文化传统。这些信息只有通过实地田野调查才能积累起来,如果把时间线拉长到十年的追踪,观察政策如何影响一个具体村庄的变迁,这种深度和系统性AI无法做到。

“AI等待被人类喂养。”她认为,AI再强大,也无法替代人类对现实的感知与回应,这恰恰是最不该放弃的能力。

(记者 李聪 编辑 陈晓舒 校对 赵琳 应受访者要求,文中严远、王子依、赵霖、彭玉为化名)